Tutti parlano di come l'intelligenza artificiale stia trasformando la traduzione, ma è davvero in grado di gestire le sfumature del linguaggio umano?

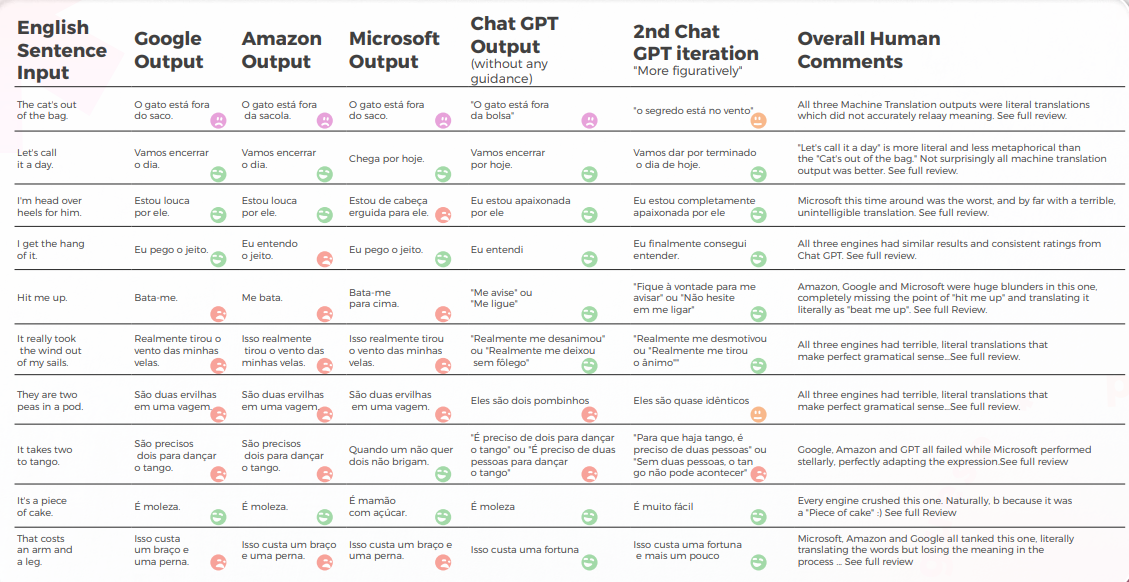

Recenti ricerche di Bureau Works hanno messo alla prova questo, confrontando GPT-3 con i principali motori di traduzione automatica di Google, Amazon e Microsoft. Lo studio si è concentrato su una delle sfide più difficili nella localizzazione: le espressioni idiomatiche. Perché? Poiché le traduzioni letterali non funzionano quando si ha a che fare con frasi come “The CAT’s out of the bag” o “Let’s call it a day.”

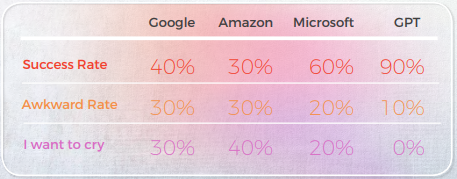

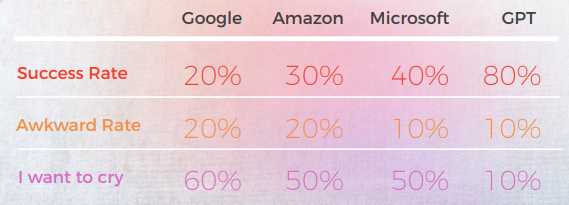

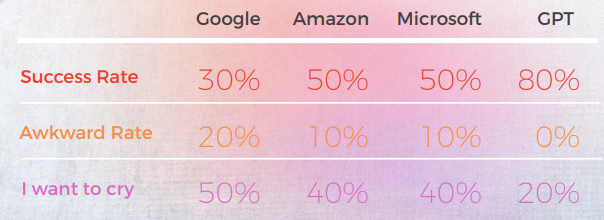

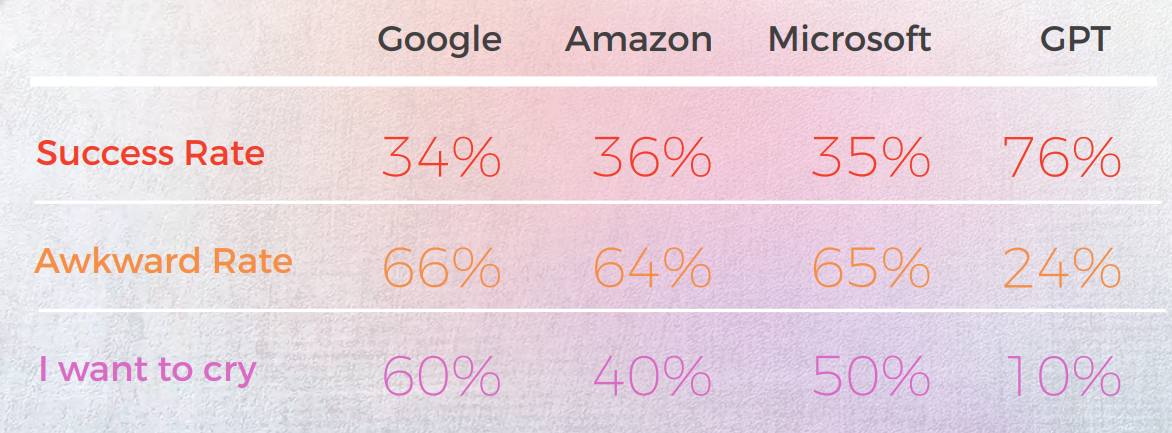

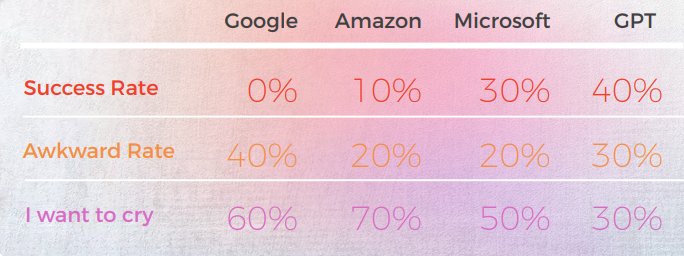

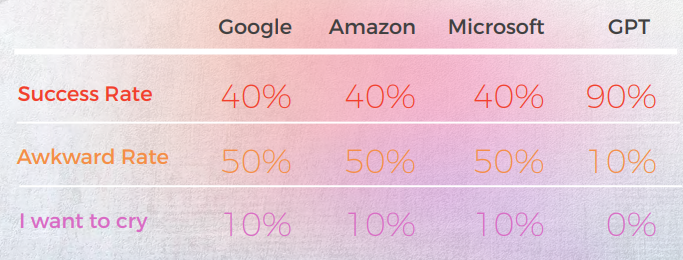

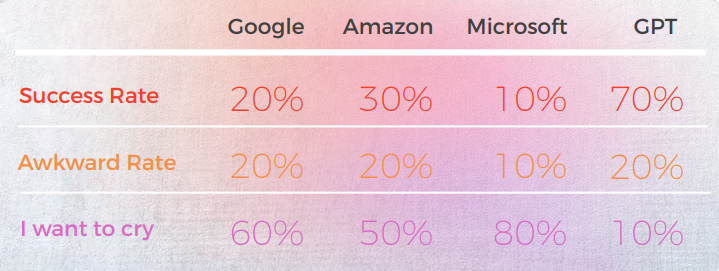

I risultati sono stati sorprendenti. GPT-3 ha fornito traduzioni accurate e dal suono naturale fino al 90% delle volte, mentre i motori tradizionali si aggiravano tra il 20% e il 50% — e spesso producevano risultati imbarazzanti valutati "Voglio piangere" dai linguisti madrelingua.

In un mondo in cui le sfumature linguistiche possono fare o distruggere il tuo messaggio, questi risultati evidenziano sia le promesse che le attuali limitazioni dell'IA nella traduzione professionale.

Ecco un Riassunto delle Nostre Principali Scoperte:

- GPT-3 ha costantemente superato i motori di traduzione automatica tradizionali (Google, Amazon, Microsoft) nella gestione delle espressioni idiomatiche, raggiungendo un'accuratezza fino al 90% in lingue come il portoghese e il cinese.

- I motori tradizionali hanno avuto difficoltà con la metafora e il linguaggio figurativo, spesso fornendo traduzioni letterali grammaticalmente corrette ma semanticamente sbagliate, alcune persino guadagnandosi valutazioni "Voglio piangere" da parte di revisori madrelingua.

- Microsoft si è assunta più rischi, offrendo traduzioni più audaci che a volte si discostavano dall'originale ma sembravano più naturali, anche se GPT ha avuto più difficoltà a valutare queste scelte creative.

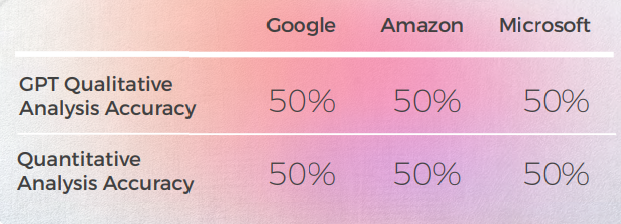

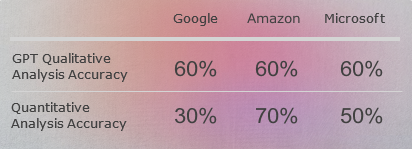

- L'analisi qualitativa di GPT è stata forte, ma ha faticato ad assegnare punteggi numerici coerenti, soprattutto quando si differenzia tra valutazioni di fascia media come 3 vs. 4.

- In quasi tutte le lingue, la seconda iterazione di GPT, quando è stata richiesta una versione più figurativa, ha migliorato la chiarezza, il tono e l'adattamento culturale.

- Il coreano è stata la lingua più impegnativa, sia per i tradizionali MT che per GPT-3, mostrando prestazioni significativamente inferiori su tutta la linea.

- GPT-3 si è dimostrato prezioso non solo come Traduttore ma anche come strumento per la valutazione e la revisione, aiutando a segnalare frasi goffe o imprecise e offrendo alternative.

GPT ha raggiunto il 90% di accuratezza negli idiomi cinesi—i MT hanno avuto difficoltà

La seguente analisi è stata scritta dal nostro linguista inglese/cinese James Hou.

Nel complesso, tutti i motori hanno lottato con la natura metaforica del linguaggio, spesso sbagliando nell'eccessiva letteralità. Ad esempio, la traduzione "chiamiamola una giornata"." è una traduzione più letterale e un po' goffa di "Let's call it a day". Trasmette il significato della frase originale, ma la formulazione è un po' goffa e potrebbe non essere così facile da capire per i madrelingua cinesi.

Sebbene trasmetta accuratamente il significato della frase originale, la formulazione è un po' goffa e potrebbe essere meno chiara per i madrelingua.

Output da una Prospettiva Qualitativa

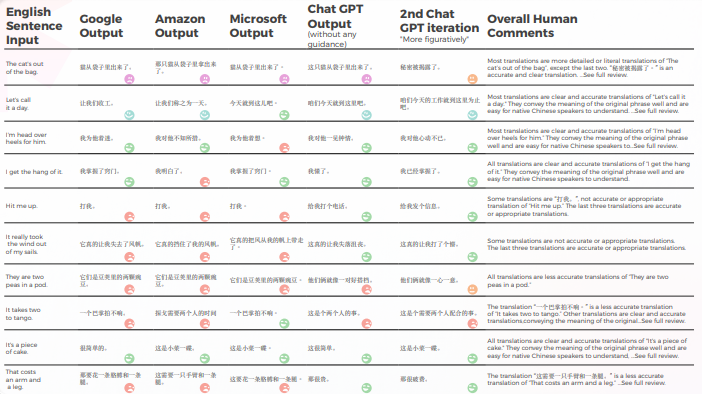

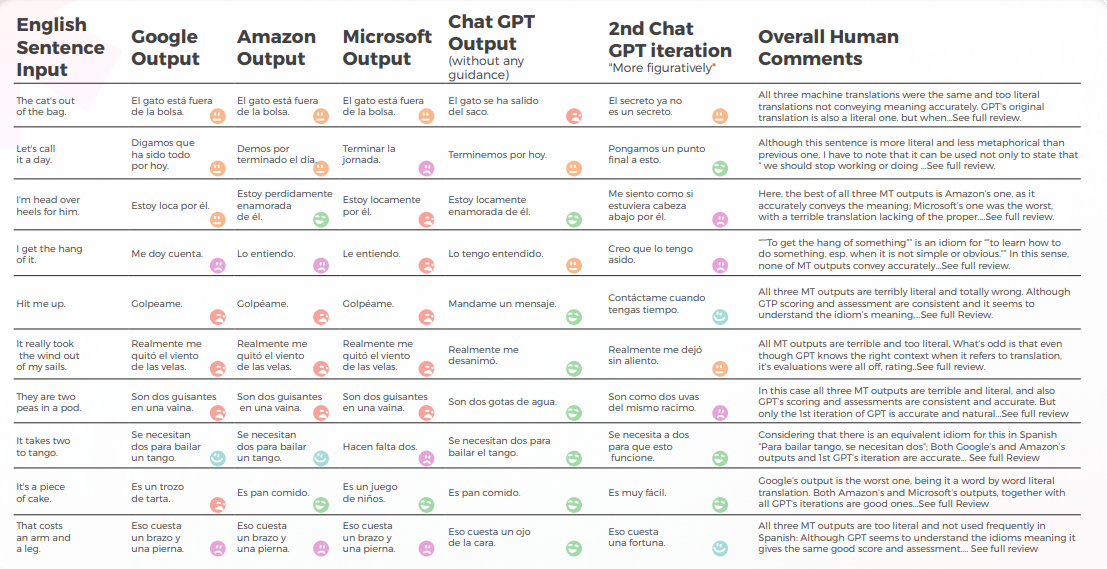

La tabella seguente presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in cinese, come condotto dal nostro team di linguisti.

Per quanto riguarda la qualità della traduzione, GPT ha fatto un ottimo lavoro con la contestualizzazione. Ad esempio, "Il segreto è stato rivelato."" è una traduzione accurata e chiara per "Il CAT è fuori dal sacco". In 9 su 10 frasi, il Contenuto era ben adattato, intelligibile e trasmetteva il significato appropriato. Contrariamente ai tre motori di traduzione automatica, GPT non ha commesso errori imbarazzanti come "voglio piangere".

La tabella seguente contiene l'analisi dei dati grezzi.

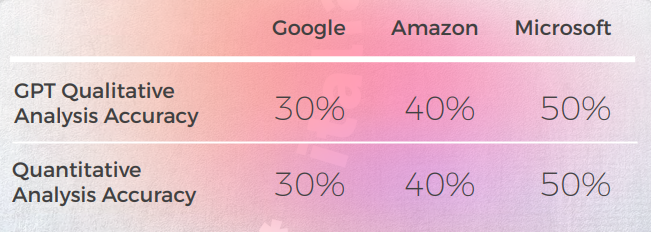

Valutazione delle GPTs Valutazione

Analisi e Principali Risultati

- Google e Amazon hanno avuto risultati estremamente simili, deviando solo leggermente l'uno dall'altro, rispecchiando gli errori e le scelte metaforiche dell'altro. Ad esempio, la traduzione "打我"." non è una traduzione accurata o appropriata di "Hit me up". La frase "Hit me up" significa contattare o mettersi in contatto con qualcuno, tipicamente tramite telefono o messaggio di testo. La frase cinese "打我" significa "colpiscimi" e non trasmette il significato della frase originale.

- Microsoft ha fatto scelte più audaci quando si tratta dell'adattamento linguistico degli idiomi.

- GPT ha avuto più difficoltà a valutare le scelte metaforiche di Microsoft man mano che si allontanavano di più.

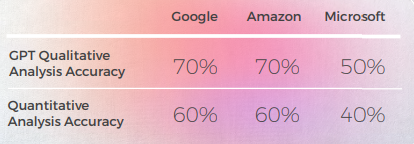

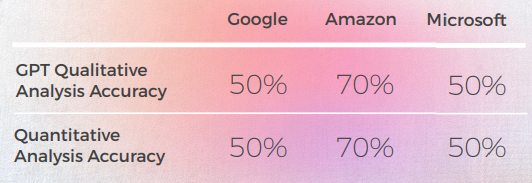

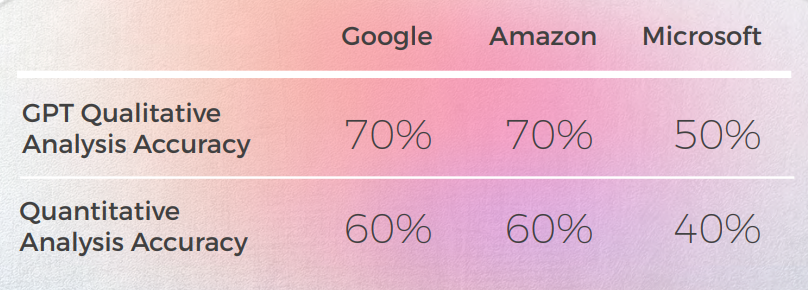

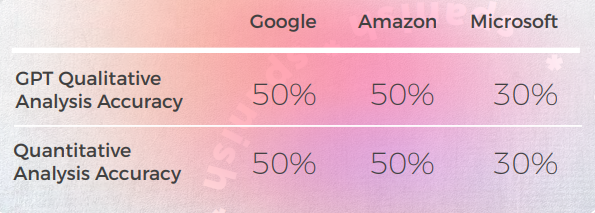

- GPT-3 ha avuto vita più facile con l'analisi qualitativa, producendo un'analisi testuale convincente (anche se con un'accuratezza solo del 70%).

- Sebbene intelligibile, l'analisi di GPT non è riuscita a identificare nel 30% dei casi. Ciò ha coinciso con scelte metaforiche che erano letterali e comprensibili, ma si discostavano dal discorso quotidiano.

- GPT-3 ha avuto più difficoltà a tradurre l'analisi qualitativa in un punteggio. Sebbene in generale i punteggi fossero accurati al 60%, era difficile distinguere tra punteggi simili come un 3 rispetto a un 4.

- L'estrema divergenza del punteggio da 1 a 5 era più facile da capire e più compatibile con i commenti generali che suggerivano che:

- Forse i criteri di punteggio non sono stati sufficientemente calibrati con GPT-3

- Forse il punteggio binario potrebbe essere più rilevante del punteggio del gradiente

- • Anche se dal punto di vista quantitativo Microsoft si è comportata in modo simile a Google e Amazon, quando si entra nei dettagli del linguaggio, Microsoft ha fatto scelte più audaci e ha fornito risultati migliori da un punto di vista qualitativo, ma era ancora molto indietro rispetto a GPT-3 per quanto riguarda l'accuratezza e l'adattamento culturale. Ad esempio, la traduzione "我掌握了窍门"." è una traduzione chiara e accurata di "Ci sto prendendo la mano". Trasmette bene il significato della frase originale ed è facile da capire per i madrelingua cinesi. È anche un modo più figurato e idiomatico di esprimere l'idea di comprendere o padroneggiare qualcosa rispetto ad altre possibili traduzioni.

Applicazioni pratiche e limitazioni

In questa analisi, GPT-3 ha fornito una contestualizzazione e un'adattamento superiori rispetto ai modelli di traduzione automatica precedenti.

Sebbene nessuno dei motori sia abbastanza affidabile da sostituire gli esseri umani (almeno nel contesto di questo studio), GPT-3 mostra una chiara capacità di assistere i Traduttori e i revisori nel processo di traduzione e valutazione della lingua.

Francese: I motori di traduzione automatica hanno fallito sul 60% degli idiomi—GPT si è distinto

La seguente analisi è stata scritta dalla nostra linguista inglese/francese Laurène Bérard.

Nel complesso, tutti i motori hanno lottato con la natura metaforica del linguaggio, spesso sbagliando nell'eccessiva letteralità.

Output da una Prospettiva Qualitativa

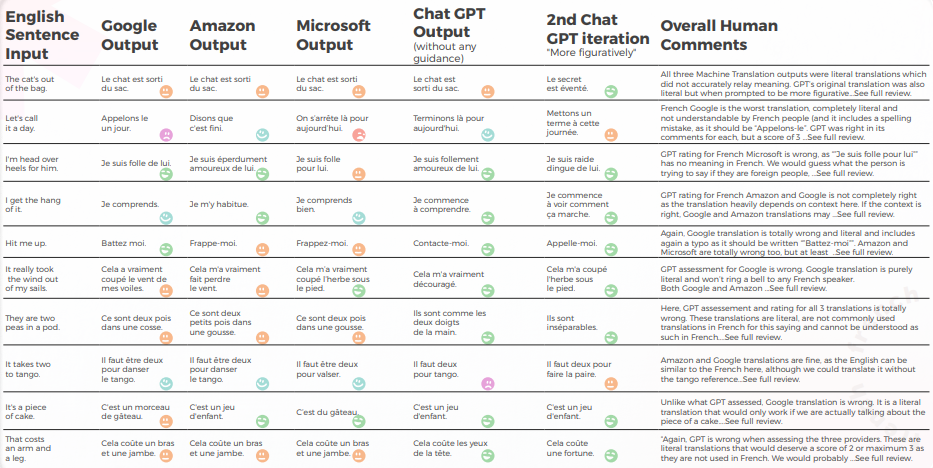

La tabella seguente presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in francese, come condotto dal nostro team di linguisti.

Per quanto riguarda la qualità della traduzione, GPT ha fatto un ottimo lavoro con la contestualizzazione. Senza alcuna guida, GPT era totalmente sbagliato per "The CAT’s out of the bag" ma era giusto con più guida, e le sue 3 traduzioni erano grammaticalmente incomplete quindi piuttosto difficili da capire per "It takes two to tango".

Il Contenuto era generalmente ben adattato, comprensibile e trasmetteva il significato appropriato. I tre motori di traduzione automatica avevano un alto tasso di "Voglio piangere" mentre anche senza contesto un traduttore avrebbe indovinato che non era inteso letteralmente (ad esempio. "Finiamola qui", che è abbastanza ovvio ma è stato totalmente frainteso dal motore di Google).

La tabella seguente contiene l'analisi dei dati grezzi.

Valutazione delle Valutazioni dei GPT

Analisi e Principali Risultati

- Nonostante la traduzione corretta 8 volte su 10, l'analisi di GPT dei 3 motori era spesso sbagliata, poiché in quasi il 50% dei casi affermava che la loro traduzione andava bene mentre non lo era.

- Sebbene l'analisi di GPT, pur essendo comprensibile, non sia riuscita a identificare problemi nel 30-50% dei casi, ciò ha coinciso con scelte letterali che sarebbero state corrette se non si fosse trattato di espressioni idiomatiche.

- GPT non è riuscito a individuare i due errori di ortografia di Google ("Appelons le" e "Battez moi").

- Le analisi qualitative e quantitative di GPT sono risultate globalmente coerenti tra loro.

- GPT ha avuto più difficoltà a valutare le traduzioni di Microsoft e Google.

- Microsoft ha fatto scelte migliori quando si tratta dell'adattamento linguistico degli idiomi.

- Google e Amazon hanno avuto risultati molto simili, solo leggermente divergenti l'uno dall'altro. Microsoft si è distinta dalle due.

- In un caso (l'espressione tango), GPT ha valutato una buona traduzione di Microsoft come errata (punteggio di 2) mentre era comprensibile e altrettanto valida delle traduzioni di Google e Amazon che GPT ha valutato positivamente (punteggio di 5). Ciò può essere spiegato dal fatto che Microsoft non era così letterale come gli altri due motori, poiché ha scelto di menzionare il valzer invece del tango.

- Microsoft ha fatto scelte più audaci e ha fornito risultati migliori da un punto di vista qualitativo, ma era ancora molto indietro rispetto a GPT in termini di accuratezza e adattamento culturale.

Applicazioni pratiche e limitazioni

In questa analisi, GPT ha fornito una contestualizzazione e un'adattamento molto migliori rispetto ai motori di traduzione automatica di Amazon, Google e Microsoft. Sebbene non sia conveniente sostituire i modelli tradizionali di traduzione automatica con modelli più grandi come GPT-3 a causa degli alti costi computazionali e dei rendimenti marginali decrescenti quando si tratta di discorsi non metaforici, GPT-3 può essere un potente alleato umano quando si tratta di fornire suggerimenti e identificare potenziali errori così come opportunità di miglioramento.

Anche se i motori di traduzione automatica sono "quasi" lì, questo "quasi" diventa progressivamente più difficile da affrontare, come dimostrato da GPT qui.

Sebbene nessuno dei motori sia abbastanza affidabile da sostituire gli esseri umani (almeno nel contesto di questo studio), GPT mostra una chiara capacità di assistere i traduttori umani e i revisori nel processo di traduzione e valutazione della lingua.

GPT ha superato tutti i motori di traduzione automatica negli idiomi tedeschi del 30%

La seguente analisi è stata scritta dalla nostra linguista inglese/tedesca Olga Schneider.

Nel complesso, GPT ha prodotto la traduzione più accurata. Analizzava sempre accuratamente la frase in inglese e di solito riusciva a capire se una traduzione automatica fosse letterale o idiomatica, ma non riusciva a rilevare un errore di traduzione il 50% delle volte.

Output da una Prospettiva Qualitativa

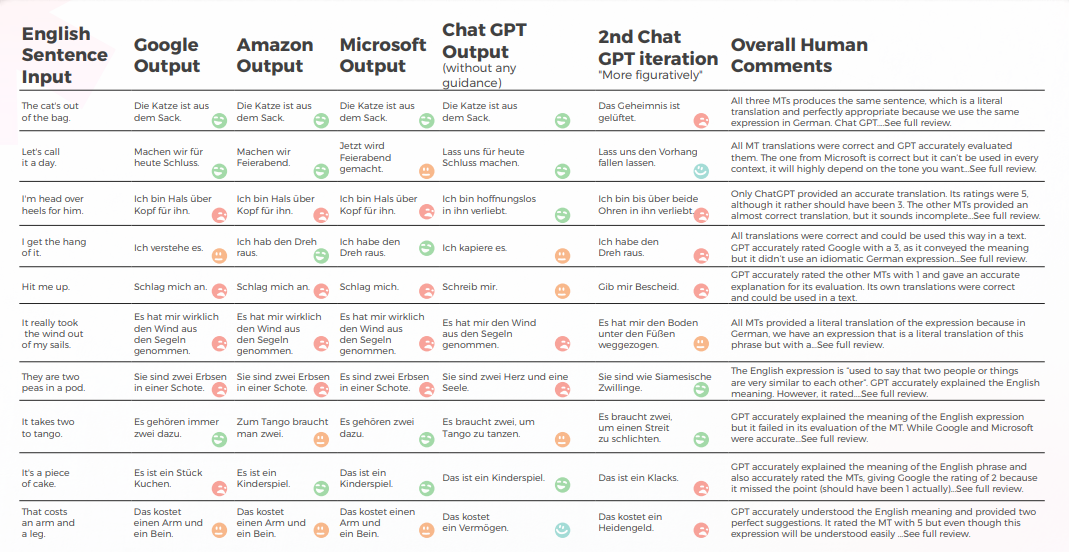

La tabella seguente presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in tedesco, come condotto dal nostro team di linguisti.

GPT produce buoni risultati 8 volte su 10 al primo tentativo e 7 volte su 10 al secondo tentativo. Ad esempio, solo GPT è stato in grado di fornire traduzioni idiomatiche accurate per "Sono pazzo di lui" e "Contattami".

L'ultimo, più figurativo output ha prodotto 4 buone frasi, con le altre che erano o tutte giuste o "Voglio piangere". Nel complesso, Amazon e Microsoft hanno prodotto traduzioni leggermente migliori di Google.

La tabella seguente contiene l'analisi dei dati grezzi.

Valutazione delle GPTs Valutazione

Analisi e Principali Risultati

- GPT ha una conoscenza abbastanza buona delle espressioni idiomatiche tedesche, anche quelle che non corrispondevano esattamente alla frase inglese erano espressioni idiomatiche di una categoria simile. Per esempio: "Tiriamo la spina" e "Caliamo il sipario" per "Chiudiamo qui per oggi". Capisce il significato generale di queste frasi relative al "finale" e potrebbe essere un'utile fonte di ispirazione.

- Quando si tratta di espressioni creative, GPT sembra prendere ispirazione dalle frasi inglesi, suggerendo la traduzione letterale tedesca di "Sono innamorato di lui dalla testa ai piedi" come alternativa creativa a "Sono pazzo di lui".

- Le valutazioni delle traduzioni di GPT erano altalenanti e si sono dimostrate inaffidabili. In un caso, ha valutato una traduzione di Google con un 2 e non era chiaro perché non fosse l'1 che avrebbe dovuto essere.

- Il tedesco e l'inglese condividono molte espressioni idiomatiche, il che rende la traduzione più facile. Tuttavia, le espressioni estranee al tedesco (ad es. "Sono due gocce d'acqua" o "È un gioco da ragazzi") finiscono per essere tradotti letteralmente. Nel caso dei piselli, a differenza dei motori di traduzione, GPT ha capito che doveva fornire espressioni su "due". Tuttavia, le espressioni che forniva, sebbene accurate e di uso comune, non trasmettevano il significato corretto.

Applicazioni pratiche e limitazioni

GPT ha fornito traduzioni migliori di Google, Amazon e Microsoft. Sebbene non sia affidabile al 100%, può fornire un punto di partenza migliore per l'editing di traduzione automatica rispetto agli altri tre motori. Mentre le espressioni idiomatiche sono importanti, c'è un altro problema che si incontra spesso nella traduzione automatica di testo dall'inglese al tedesco: una struttura della frase ingombrante che è troppo vicina al testo originale. Sarebbe importante vedere come GPT risolve questo problema.

Quando si tratta di valutazione, GPT non è un buon strumento, poiché la sua valutazione delle traduzioni in tedesco è accurata solo al 50%.

Altre tre cose sarebbero state interessanti da vedere:

- GPT può competere con DeepL per il tedesco? Sebbene GPT possa fornire buone traduzioni, DeepL produce buone traduzioni in tedesco e offre anche una gamma di caratteristiche che semplificano il processo di traduzione (termini del glossario tradotti correttamente con il plurale e il caso corretti, modifica con un clic, completamento automatico delle frasi dopo aver digitato una o due parole per velocizzare la riformulazione). La traduzione di GPT deve essere significativamente migliore di quella di DeepL per compensare la mancanza di caratteristiche.

- L'accuratezza di GPT potrebbe essere migliorata con un maggiore contesto, ad esempio un paragrafo contenente la frase?

- Se Google è in grado di riconoscere il testo generato dall'intelligenza artificiale, come gestirà le traduzioni GPT con modifiche minime o nulle? È in grado di rilevare lo "stile GPT" e penalizzare un testo nei risultati di ricerca?

In sintesi, allo stato attuale, GPT può essere una fonte di ispirazione per i nostri cervelli umani limitati. Può fornire traduzioni decenti. Più di questo, può aiutarci a riformulare espressioni abusate, trova metafore e pensare fuori dagli schemi.

Italiano: I motori di traduzione automatica hanno restituito traduzioni letterali nel 70% dei casi

La seguente analisi è stata scritta dalla nostra linguista inglese/italiana Elvira Bianco.

Nel complesso, tutti i motori hanno lottato con la natura metaforica del linguaggio, spesso sbagliando nell'eccessiva letteralità.

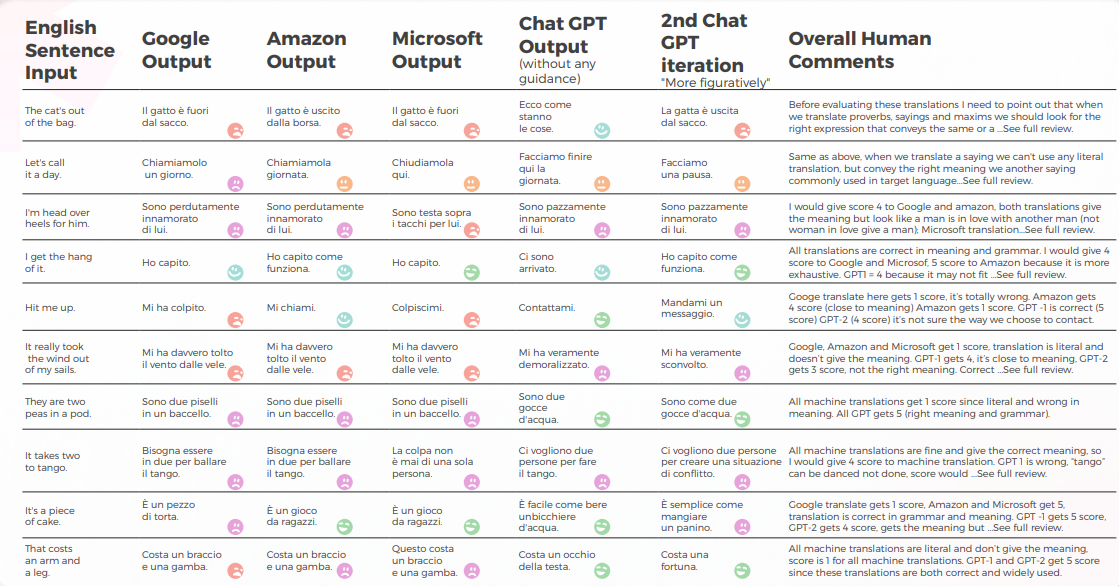

Output da una Prospettiva Qualitativa

La tabella seguente presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in italiano, come condotto dal nostro team di linguisti.

La traduzione automatica ha fornito una traduzione letterale molto lontana dal significato corretto. GPT ha trasmesso il significato e l'espressione corretti al 70%, per il restante 30% ha utilizzato espressioni accettabili che non sono ampiamente utilizzate o percepite come linguaggio nativo naturale.

La tabella seguente contiene l'analisi dei dati grezzi.

Valutazione delle Valutazioni di GPT

Analisi e Principali Risultati

- Google Translate ottiene solo una traduzione giusta e si avvicina al significato in 2 frasi.

- Amazon ha dato il 50% di giusto significato anche se non utilizzando il modo più comune per trasmettere il detto inglese in lingua italiana.

- Microsoft ha dato 3 giuste risposte avvicinandosi a detti simili italiani.

- Mentre il 1° Chat GPT di solito approva le traduzioni automatiche, il 2° e il 3° Chat GPT di solito danno il significato corretto e aggiungono preziosi suggerimenti di traduzione.

Applicazioni pratiche e limitazioni

Come definito da https://it.wiktionary.org/wiki/espressione_idiomatica, un'espressione idiomatica tipica di una lingua è solitamente intraducibile letteralmente in altre lingue, a meno che non si ricorra a espressioni idiomatiche della lingua in cui è tradotta con significati simili alle espressioni idiomatiche della lingua da cui è tradotta. Chiaramente la traduzione meccanica prodotta dalle macchine di traduzione più utilizzate oggi (Google, Amazon, Microsoft) era inaffidabile, nonostante GPT-3 si sia dimostrato capace al 70% di dare il giusto significato e di fornire buoni suggerimenti nell'adattamento del Contenuto.

Non è improbabile che in un futuro prossimo le macchine memorizzino anche le espressioni idiomatiche, ma giusto ora abbiamo bisogno di umani per tradurre trasmettendo lo stesso significato da una lingua all'altra.

Le lingue sono piene di sfumature, doppi sensi, allusioni, modi di dire, metafore che solo un essere umano può percepire.

Il coreano ha avuto la precisione più bassa tra tutti i motori testati

L'analisi seguente è stata scritta dal nostro linguista inglese/coreano Sun Min Kim.

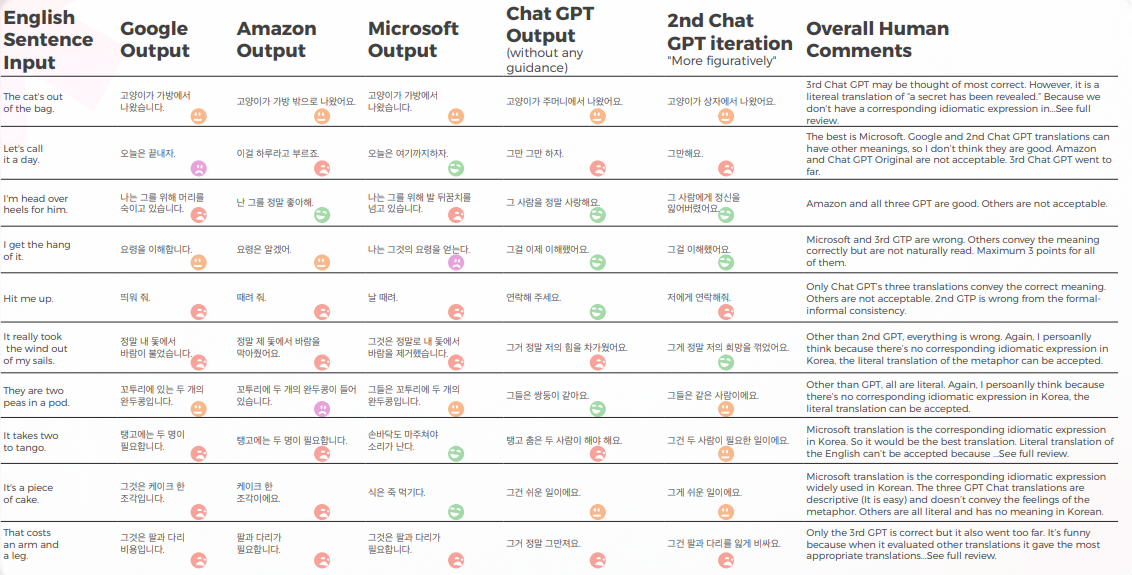

Output da una Prospettiva Qualitativa

La tabella sottostante presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in coreano, come condotto dal nostro team di linguisti.

La maggior parte dei motori traduce letteralmente le espressioni idiomatiche, mentre GPT cerca di tradurre nel modo più descrittivo possibile senza usare metafore (es. pezzo di torta = facile, mentre in Corea abbiamo un'espressione idiomatica simile che trasmette lo stesso significato di Microsoft.

Le tre traduzioni di GPT non sono coerenti. Alcuni stanno peggiorando con l'iterazione.

La tabella seguente contiene l'analisi dei dati grezzi.

GPT conosce i problemi quando le traduzioni vanno male. Ma non è considerato corretto nel giudicare il migliore.

GPT stesso ha problemi con il trattamento formale – informale e così via) e può valutare questo problema.

Valutazione dei GPTs Valutazione

Analisi e Principali Risultati

Poiché gli originali in inglese in questo studio sono espressioni idiomatiche, è un po' complicato perché devi scegliere tra la metafora o la descrizione diretta. Ma per alcune espressioni idiomatiche in cui la lingua coreana ha espressioni idiomatiche simili che trasmettono lo stesso significato, la maggior parte dei motori non è riuscita a trovare quelle espressioni con poche eccezioni (si prega di vedere il foglio di lavoro e trova quelle con il punteggio di 5 da parte mia).

Per altre, il mio pensiero personale è che se la metafora stessa può trasmettere il significato, la traduzione letterale può essere considerata e forse è meglio usare una parola descrittiva. Naturalmente, se la metafora non ha un contesto culturale in Corea, non dovrebbe essere tradotta letteralmente. Ma è una questione sottile e forse dipende dalla preferenza o dalle emozioni umane del Traduttore. Non credo che nessun motore abbia ancora quel livello di pensiero umano.

Applicazioni pratiche e limitazioni

Penso che la maggior parte dei motori possa essere utilizzata per scopi di pre-traduzione. Ma considerando la Qualità, dovrebbe essere principalmente per scopi di efficienza (cioè, non digitare da zero). Per testi più descrittivi, come i manuali, vedo che l'MTPE è molto più avanzato di queste espressioni idiomatiche. Quindi, c'è ancora spazio per migliorare.

GPT ha raggiunto il 90% di successo nei modi di dire in portoghese brasiliano

La seguente analisi è stata scritta dal nostro linguista inglese/portoghese Gabriel Fairman.

Nel complesso, tutti i motori hanno lottato con la natura metaforica del linguaggio, spesso sbagliando nell'eccessiva letteralità.

Output da una Prospettiva Qualitativa

La tabella sottostante presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in portoghese, come condotto dal nostro team di linguisti.

La maggior parte dei motori traduce letteralmente le espressioni idiomatiche, mentre GPT cerca di tradurre nel modo più descrittivo possibile senza usare metafore (es. pezzo di torta = facile, mentre in Corea abbiamo un'espressione idiomatica simile che trasmette lo stesso significato di Microsoft.

Le tre traduzioni di GPT non sono coerenti. Alcuni stanno peggiorando con l'iterazione.

La tabella seguente contiene l'analisi dei dati grezzi.

Per quanto riguarda la qualità della traduzione, GPT ha fatto un ottimo lavoro con la contestualizzazione. In 9 su 10 frasi, il Contenuto era ben adattato, intelligibile e trasmetteva il significato appropriato. Contrariamente ai tre motori di traduzione automatica, GPT non ha commesso errori imbarazzanti come "voglio piangere".

L'ipotesi iniziale era che ci sarebbe stata una grande differenza nella Qualità tra la prima e la seconda iterazione di GPT, ma la Qualità della traduzione era simile in entrambe.

Valutazione della Valutazione di GPTs

Analisi e Principali Risultati

- Microsoft ha fatto scelte più audaci quando si tratta dell'adattamento linguistico degli idiomi.

- GPT ha avuto più difficoltà a valutare le scelte metaforiche di Microsoft man mano che si allontanavano di più.

- Google e Amazon hanno avuto risultati estremamente simili, solo leggermente divergenti l'uno dall'altro, rispecchiando gli errori e le scelte metaforiche dell'altro. Microsoft si è chiaramente distinta dai due.

- GPT-3 ha avuto vita più facile con l'analisi qualitativa, producendo un'analisi testuale convincente (anche se con un'accuratezza solo del 70%).

- Sebbene intelligibile, l'analisi di GPT non è riuscita a identificare nel 30% dei casi. Ciò ha coinciso con scelte metaforiche che erano letterali e comprensibili, ma si discostavano dal discorso quotidiano.

- GPT-3 ha avuto più difficoltà a tradurre l'analisi qualitativa in un punteggio.

- Sebbene in generale i punteggi fossero accurati al 60%, era difficile distinguere tra punteggi simili come un 3 rispetto a un 4.

- L'estrema divergenza del punteggio da 1 a 5 era più facile da capire e più compatibile con i commenti generali che suggerivano che:

- Forse i criteri di punteggio non sono stati sufficientemente calibrati con GPT-3

- Forse il punteggio binario potrebbe essere più rilevante del punteggio a gradiente. In un caso anomalo, Chat GPT-3 ha valutato due traduzioni simili in modi radicalmente diversi, dando a una un 1 e all'altra un 5, quando entrambe avrebbero dovuto essere 1.

- Anche se dal punto di vista quantitativo Microsoft si è comportata in modo simile a Google e Amazon, quando si entra nel vivo del linguaggio, Microsoft ha fatto scelte più audaci e ha fornito risultati migliori da un punto di vista qualitativo, ma era ancora molto indietro rispetto a GPT-3 per quanto riguarda l'accuratezza e l'adattamento culturale.

Applicazioni pratiche e limitazioni

In questa analisi, GPT-3 ha fornito una contestualizzazione e un'adattamento superiori rispetto ai precedenti modelli di traduzione automatica in portoghese brasiliano. Sebbene non sia conveniente sostituire i modelli tradizionali di traduzione automatica con modelli più grandi come GPT-3 a causa degli alti costi computazionali e dei rendimenti marginali decrescenti quando si tratta di discorsi non metaforici, GPT-3 può essere un potente alleato umano quando si tratta di fornire suggerimenti e identificare potenziali errori, nonché opportunità di miglioramento.

I casi limite linguistici sono sorprendenti perché illustrano così chiaramente quanto rimane in così poco quando si tratta di modelli di linguista. Anche se sono "quasi" lì, questo "quasi" diventa progressivamente più difficile da affrontare e, se non più difficile, decisamente più costoso da un punto di vista computazionale.

Sebbene nessuno dei motori sia abbastanza affidabile da sostituire gli esseri umani (almeno nel contesto di questo studio), GPT-3 mostra una chiara capacità di assistere i traduttori umani e i revisori nel processo di traduzione e valutazione della lingua.

I traduttori automatici spagnoli hanno ottenuto meno del 30%—GPT è stato il chiaro vincitore

La seguente analisi è stata scritta dal nostro linguista inglese/spagnolo Nicolas Davila.

Nel complesso, tutti i motori hanno lottato con la natura metaforica del linguaggio, spesso sbagliando nell'eccessiva letteralità.

Output da una Prospettiva Qualitativa

La tabella seguente presenta un'analisi sintetica di 10 frasi idiomatiche inglesi tradotte in spagnolo, come condotto dal nostro team di linguisti.

Per quanto riguarda la qualità della traduzione, GPT ha fatto un lavoro accettabile e migliore degli altri per quanto riguarda la contestualizzazione. In 7 su 10 frasi, il Contenuto era comprensibile, ben formato e trasmetteva il significato appropriato, con un basso tasso di goffaggine e di "voglio piangere".

Sebbene l'ipotesi iniziale fosse che ci sarebbe stata una grande differenza nella qualità tra la prima e le successive iterazioni di GPT, la qualità della traduzione è simile in tutte loro, la 2a e la 3a iterazione a volte aggiungono cose non necessarie, aumentando un po' il tasso di stranezza.

La tabella seguente contiene l'analisi dei dati grezzi.

Valutazione delle GPTs Valutazione

Analisi e Principali Risultati

- Le traduzioni MT erano troppo letterali, con Amazon e Google molto simili in termini generali, e Microsoft essendo la peggiore.

- Google e Amazon hanno avuto risultati estremamente simili, solo leggermente divergenti l'uno dall'altro, rispecchiando gli errori e le scelte metaforiche dell'altro. Microsoft ha avuto una performance scadente, a volte producendo frasi mal formate e mancanti di alcune parti della costruzione grammaticale.

- GPT-3 ha avuto più facilità con l'analisi qualitativa, producendo un'analisi testuale coerente, anche se con un'accuratezza solo del 50%.

- Spesso, l'analisi qualitativa di GPT-3 era troppo generica e più limitata al significato principale e letterale della frase, senza considerare i sottili dettagli di costruzione e cambiamento di significato. Sembra che GPT non sia in grado di cogliere tali differenze e di tradurle in punteggi quantitativi.

- Inoltre, GPT assegnava spesso la stessa analisi qualitativa e un punteggio quantitativo elevato a frasi grammaticalmente mal costruite, il che sembra essere una limitazione del modello di GPT.

- GPT-3 ha avuto più difficoltà a tradurre l'analisi qualitativa in un punteggio.

- Essendo accurato solo al 50% per Google e Amazon e solo al 30% per Microsoft. Sembra che GPT stesse misurando solo se la frase trasmetteva il significato, ma non le differenze nella costruzione o nella buona formazione.

- La divergenza del punteggio da 1 a 5 era più facile da capire e più compatibile con i commenti generali che suggerivano che: Forse i criteri di punteggio non sono stati sufficientemente calibrati per GPT-3. Forse il punteggio binario potrebbe essere più rilevante del punteggio del gradiente. Forse i criteri di valutazione o il modello GPT non consideravano i problemi grammaticali, ma solo la trasmissione del significato.

Applicazioni pratiche e limitazioni

In questa analisi, GPT-3 ha fornito una contestualizzazione e un'adattamento superiori rispetto ai precedenti modelli di traduzione automatica in spagnolo latinoamericano.

GPT-3 potrebbe essere uno strumento potente per aiutare gli esseri umani a migliorare le traduzioni quando si tratta di fornire suggerimenti utili e opportunità di miglioramento. Ma, per quanto posso vedere, ha ancora alcune limitazioni.

Anche se modelli più grandi come GPT-3 potrebbero essere utili, non è conveniente sostituire i modelli tradizionali di traduzione automatica con essi, a causa dei costi computazionali più elevati, poiché quando si tratta di testo non metaforico potrebbe ridurre i guadagni marginali.

Mentre GPT-3 mostra una chiara capacità di assistere i traduttori umani e i revisori nel processo di traduzione e valutazione della lingua, le considerazioni sui costi dovrebbero essere incluse quando si valuta il suo utilizzo per testi non metaforici.

Conclusioni

Sebbene le prestazioni di ChatGPT possano variare a seconda del prompt e della lingua specifica, il nostro studio suggerisce che ChatGPT ha il potenziale per produrre traduzioni di Qualità superiore rispetto ai motori di traduzione automatica tradizionali, specialmente quando si tratta di gestire espressioni idiomatiche e l'uso sfumato della lingua.

Tuttavia, è importante notare che ChatGPT è ben lungi dal non commettere errori e ha ancora un immenso margine di miglioramento, soprattutto quando si tratta di prompt o domini linguistici più complessi.

Come Traduttore, ChatGPT ha avuto più successo di tutti i motori di traduzione automatica testati. Mentre le lingue hanno mostrato risultati diversi, il coreano era chiaramente l'eccezione con la Qualità MT e la Qualità GPT significativamente inferiori rispetto ad altre lingue.

In tutte le lingue tranne il coreano, ChatGPT ha avuto almeno una percentuale di successo del 70% e al massimo una percentuale di successo del 90%, con prestazioni migliori rispetto alla traduzione automatica tradizionale. E anche in coreano, sebbene i punteggi fossero bassi, erano comunque migliori dell'output del motore MT.

Contrariamente alla traduzione automatica, con un LLM, le iterazioni dello stesso contenuto possono migliorare la qualità dell'output. Questo è principale quando si pensa alle integrazioni perché, mentre con il MT tradizionale il tuo output sarà sempre lo stesso del tuo input (a meno che il motore non riceva ulteriori dati o addestramento), con un LLM si possono esplorare diverse interazioni tramite API per ottimizzare la qualità del feed.

Un vantaggio di ChatGPT rispetto ai tradizionali motori di traduzione automatica è la sua capacità di apprendere e migliorare nel tempo, anche senza ulteriori dati di addestramento. Ciò è dovuto alla natura degli LLM, che sono progettati per perfezionare continuamente i loro modelli linguistici in base a nuovi input. Pertanto, ChatGPT può potenzialmente offrire capacità di traduzione più adattive e dinamiche, il che potrebbe essere particolarmente utile in scenari in cui la lingua o il Contenuto è in continua evoluzione o cambiamento.

Un altro vantaggio di ChatGPT è il suo basso tasso di cringe, che rappresenta un miglioramento significativo rispetto ai tradizionali motori di traduzione automatica che spesso producono traduzioni imbarazzanti o inappropriate. Questo potrebbe rendere ChatGPT più accettabile e facile da usare per gli utenti non esperti che potrebbero non avere lo stesso livello di conoscenza linguistica o culturale dei traduttori professionisti.

Tuttavia, è importante notare che ChatGPT non è un sostituto per i traduttori umani, e ci sono una miriade di casi in cui sono necessarie l'esperienza e il giudizio di un traduttore umano. Ma i tassi di cringe significativamente più bassi di ChatGPT aprono la strada a una più ampia adozione di traduzioni non guidate dall'uomo.

In qualità di valutatore, le prestazioni di ChatGPT sono state più contrastanti, con tassi di precisione compresi tra il 30% e il 70%. Sebbene questo suggerisca che ChatGPT potrebbe non essere altrettanto efficace nel valutare altri motori di traduzione quanto lo è nel suggerire traduzioni, è possibile che ciò sia dovuto alla complessità e alla Qualità dei prompt di valutazione, che potrebbero richiedere conoscenze più specializzate o contestuali di quelle attualmente possedute da ChatGPT. Sono necessarie ulteriori ricerche per esplorare il potenziale di ChatGPT come valutatore, nonché i suoi limiti e le sue sfide.Nel complesso, il nostro studio suggerisce che ChatGPT ha capacità di traduzione promettenti che vale la pena esplorare ulteriormente. Sebbene potrebbe non essere in grado di sostituire o bypassare i traduttori umani interamente, potrebbe potenzialmente offrire benefici significativi come strumento di supporto o di pre-traduzione, specialmente in scenari in cui il tempo, le risorse o l'esperienza sono limitati.

Come con qualsiasi tecnologia emergente, ci sono ancora molte sfide e opportunità di miglioramento, e saranno necessarie ulteriori ricerche e sperimentazioni per sbloccare completamente il suo potenziale.

Metodologia

Per esplorare come i modelli linguistici come GPT-3 gestiscono la traduzione idiomatica rispetto ai tradizionali motori di traduzione automatica, abbiamo condotto un esperimento focalizzato su casi limite linguistici che coinvolgono metafore ed espressioni idiomatiche.

Selezione di Espressioni Idiomatiche

Abbiamo selezionato 10 modi di dire inglesi comunemente usati, come “Let’s call it a day,” “Hit me up,” e “The CAT’s out of the bag.” Queste espressioni sono ben note per mettere alla prova i sistemi di traduzione, poiché richiedono un'adattamento culturale e contestuale piuttosto che un'equivalenza letterale.

Motori e modelli di traduzione testati

Ogni modo di dire è stato tradotto utilizzando:

- Google Translate

- Amazon Translate

- Microsoft Traduttore

- GPT-3 (ChatGPT) – utilizzando due approcci:

- Una traduzione diretta senza alcuna guida

- Una seconda versione sollecitata per essere più figurativa e idiomatica

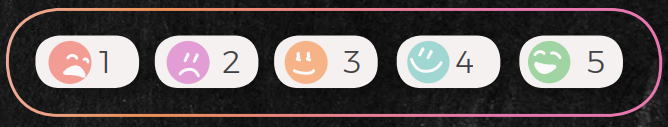

Processo di valutazione

Gli output tradotti sono stati esaminati da linguisti madrelingua in sette lingue di destinazione: Portoghese brasiliano, spagnolo, francese, tedesco, italiano, cinese e coreano. Per ogni frase, i revisori hanno valutato:

- Se il significato dell'espressione idiomatica originale è stato preservato

- La naturalezza dell'espressione nella lingua di destinazione

- Grammatica, sintassi e accuratezza semantica

Ogni traduzione è stata valutata su una scala da 1 a 5:

- 5: Significato corretto e linguaggio dal suono naturale

- 1: Traduzione errata, confusa o innaturale (livello "Voglio piangere")

Inoltre, abbiamo chiesto a ChatGPT di valutare le traduzioni degli altri motori, sia fornendo feedback testuali qualitativi che punteggi numerici. Questo ci ha permesso di valutare la sua capacità come valutatore, non solo come generatore di traduzioni.

Limitazioni dello studio

È importante notare che si trattava di uno studio esplorativo:

- Il campione era limitato a 10 modi di dire con un revisore umano per lingua.

- Tutte le valutazioni comportano un certo grado di soggettività e preferenza individuale.

- Le prestazioni di GPT-3 riflettono una versione specifica del modello e possono evolvere con gli aggiornamenti.

Nonostante questi vincoli, i risultati forniscono preziose intuizioni sulle capacità e limitazioni dei modelli attuali, specialmente in scenari linguisticamente sfumati e culturalmente dipendenti.

Avvertenze

(Avvertenze di ricerca reale da non prendere alla leggera)

Mentre abbiamo cercato di esplorare il potenziale delle capacità linguistiche di ChatGPT, è importante notare che questo studio ha valutato solo un aspetto della traduzione, ovvero la capacità di gestire casi limite altamente metaforici e idiomatici. Altri aspetti della traduzione, come la comprensione culturale e contestuale, possono richiedere metodi e criteri di valutazione diversi.

La dimensione del campione di questo studio è limitata a 10 modi di dire e un revisore per lingua, il che potrebbe non essere rappresentativo dell'intera gamma di espressioni idiomatiche nella lingua inglese, o della gamma di prospettive e competenze dei Traduttori professionisti. Pertanto, i risultati di questo studio devono essere interpretati con cautela e non possono essere generalizzati ad altri contesti o domini.

Inoltre, le opinioni e le valutazioni del singolo recensore per lingua sono soggettive e possono essere influenzate da pregiudizi, esperienze o preferenze personali. Come per qualsiasi valutazione soggettiva, c'è un certo grado di variabilità e incertezza nei risultati. Per aumentare l'affidabilità e la validità dei nostri trova, studi futuri potrebbero coinvolgere più revisori, valutazioni cieche o misure di affidabilità tra valutatori.

Vale anche la pena notare che le capacità linguistiche di ChatGPT non sono statiche e possono cambiare nel tempo man mano che il modello viene ulteriormente addestrato e perfezionato. Pertanto, i risultati di questo studio devono essere considerati come un'istantanea delle prestazioni del modello in un momento specifico e potrebbero non riflettere le sue capacità attuali o future.

Infine, questo studio non intende fare affermazioni definitive o categoriche sull'utilità o sui limiti di ChatGPT per la traduzione. Anzi, è pensato per servire come un'indagine preliminare e punto di partenza per future ricerche e sviluppo nel campo dell'elaborazione del linguaggio naturale e della traduzione automatica. Come con qualsiasi tecnologia emergente, ci sono ancora molte sfide e opportunità di miglioramento, e saranno necessari ulteriori esperimenti e Collaborazione per esplorarne appieno il potenziale.

Unlock the power of glocalization with our Translation Management System.

Unlock the power of

with our Translation Management System.